احمقانه ترین اتفاقات دنیای تکنولوژی در سالی که گذشت

- رهبران فناوری از تاکتیکهای عجیب و غریب استخدام استفاده میکنند، از تحویل سوپ شخصی گرفته تا ساخت لگو با قرارداد عدم افشا.

- نگرانیهای مربوط به حریم خصوصی با دستگاههای هوشمند افزایش مییابد، زیرا "رمزگذاری سرتاسری" دوربین توالت گمراهکننده از آب درمیآید.

صنعت تکنولوژی با چنان سرعتی حرکت میکند که پیگیری تمام اتفاقات امسال دشوار است. شاهد بودیم که نخبگان تکنولوژی خود را درگیر دولت آمریکا کردند، شرکتهای هوش مصنوعی برای سلطه با هم درگیر شدند، و تکنولوژیهای آیندهنگرانه مانند عینکهای هوشمند و تاکسیهای رباتیک کمی ملموستر شدند، فراتر از حباب سانفرانسیسکو. میدانید، مسائل مهمی که سالها بر زندگی ما تأثیر خواهند گذاشت.

اما دنیای تکنولوژی سرشار از شخصیتهای بزرگ است، بنابراین همیشه اتفاقات واقعاً احمقانهای در جریان است که وقتی کل اینترنت از کار میافتد، یا تیکتاک فروخته میشود، یا یک نشت اطلاعات عظیم رخ میدهد، به طور قابل درکی تحتالشعاع "اخبار واقعی" قرار میگیرند. بنابراین، با توجه به اینکه (امیدواریم) اخبار کمی آرامتر شده است، وقت آن است که لحظات احمقانهای را که از دست دادهاید، مرور کنیم – نگران نباشید، فقط یکی از آنها مربوط به توالت است.

مارک زاکربرگ از مارک زاکربرگ شکایت کرد

مارک زاکربرگ، وکیل ورشکستگی اهل ایندیانا، از مارک زاکربرگ، مدیرعامل متا، شکایت کرد.

تقصیر مارک زاکربرگ نیست که اسمش مارک زاکربرگ است. اما، مانند میلیونها صاحب کسبوکار دیگر، مارک زاکربرگ برای تبلیغ حرفه حقوقی خود به مشتریان بالقوه، از تبلیغات فیسبوک استفاده کرد. صفحه فیسبوک مارک زاکربرگ به طور مداوم به دلیل جعل هویت مارک زاکربرگ، به طور ناموجهی مسدود میشد. بنابراین، مارک زاکربرگ اقدام قانونی کرد زیرا مجبور بود برای تبلیغات در طول دوره تعلیق خود هزینه بپردازد، حتی با وجود اینکه هیچ قانونی را نقض نکرده بود.

این یک ناراحتی مداوم برای مارک زاکربرگ بوده است که از زمانی که مارک زاکربرگ سه ساله بود، مشغول وکالت بوده است. مارک زاکربرگ حتی وبسایتی به نام iammarkzuckerberg.com ایجاد کرد تا به مشتریان بالقوه خود توضیح دهد که او مارک زاکربرگ نیست.

او در وبسایت خود نوشت: «من نمیتوانم از نامم هنگام رزرو یا انجام کارهای تجاری استفاده کنم، زیرا مردم فکر میکنند من یک تماسگیرنده شوخی هستم و تلفن را قطع میکنند.» «زندگی من گاهی اوقات شبیه تبلیغ مایکل جردن در ESPN است، جایی که نام یک فرد عادی باعث اشتباهات مداوم میشود.»

وکلای متا احتمالاً خیلی مشغول هستند، بنابراین ممکن است مدتی طول بکشد تا مارک زاکربرگ بفهمد این موضوع چگونه پیش خواهد رفت. اما باور کنید یا نه، من یک یادآور در تقویم برای مهلت بعدی ثبت پرونده در این پرونده تنظیم کردم (اگر میپرسید، ۲۰ فوریه است).

سوهام پارخ دره سیلیکون ولی را فریب داد

همه چیز از زمانی شروع شد که سهیل دوشی، بنیانگذار Mixpanel، در X پستی منتشر کرد تا کارآفرینان دیگر را در مورد مهندسی امیدوارکننده به نام سوهام پارخ هشدار دهد. دوشی پارخ را برای کار در شرکت جدیدش استخدام کرده بود، سپس به سرعت متوجه شد که او همزمان برای چندین شرکت کار میکند.

دوشی در X نوشت: «من این مرد را در هفته اول اخراج کردم و به او گفتم که دروغ گفتن/کلاهبرداری از مردم را متوقف کند. او یک سال بعد هم متوقف نشده است. دیگر بهانهای نیست.»

مشخص شد که دوشی تنها نبود – او گفت که فقط در همان روز، سه بنیانگذار با او تماس گرفته بودند تا از هشدارش تشکر کنند، زیرا آنها در حال حاضر پارخ را استخدام کرده بودند.

اطلاعیه مهم: مردی به نام سوهام پارخ (در هند) وجود دارد که همزمان در ۳-۴ استارتاپ کار میکند. او شرکتهای YC و موارد دیگر را شکار کرده است. مراقب باشید.

من این مرد را در هفته اول اخراج کردم و به او گفتم که دروغ گفتن/کلاهبرداری از مردم را متوقف کند. او یک سال بعد هم متوقف نشده است. دیگر بهانهای نیست.

— سهیل (@Suhail) ۲ ژوئیه ۲۰۲۵

برای برخی، پارخ یک کلاهبردار بیاخلاق بود که استارتاپها را برای پول سریع استثمار میکرد. برای دیگران، او یک افسانه بود. با کنار گذاشتن اخلاقیات، استخدام در این تعداد شرکت واقعاً چشمگیر است، زیرا استخدام در حوزه تکنولوژی میتواند بسیار رقابتی باشد.

کریس باک، بنیانگذار پلتفرم تطبیق شغل Laskie، در X نوشت: «سوهام پارخ باید یک شرکت آمادگی مصاحبه راهاندازی کند. او به وضوح یکی از بهترین مصاحبهکنندگان تمام دوران است.» «او باید علناً اعتراف کند که کار بدی انجام داده و به کاری که در آن ۱٪ برتر است، بازگردد.»

پارخ اعتراف کرد که در واقع، گناهکار کار کردن همزمان در چندین شرکت بوده است. اما هنوز سوالات بیپاسخی در مورد داستان او وجود دارد – او ادعا میکند که برای پول درآوردن به همه این شرکتها دروغ میگفته است، اما او به طور منظم در بستههای جبرانی خود، سهام بیشتری نسبت به پول نقد انتخاب میکرد (سهام ممکن است سالها طول بکشد تا وِست شود، و پارخ نسبتاً سریع اخراج میشد). واقعاً چه اتفاقی در آنجا میافتاد؟ سوهام، اگر میخواهی صحبت کنی، پیامهای خصوصی من باز است.

اگر سوهام بلافاصله اعتراف کند و بگوید که برای آموزش یک عامل هوش مصنوعی برای کارهای دانشی کار میکرده است، آخر هفته با ارزش ۱۰۰ میلیون دلاری پیش از سرمایهگذاری، جذب سرمایه خواهد کرد.

— آرون لوی (@levie) ۲ ژوئیه ۲۰۲۵

سم آلتمن ظاهراً روغن زیتون را اشتباه استفاده کرد

مدیران عامل تکنولوژی انتقادات زیادی دریافت میکنند، اما معمولاً نه به خاطر آشپزیشان. اما وقتی سم آلتمن، مدیرعامل OpenAI، به Financial Times (FT) برای سری برنامه «ناهار با FT» پیوست. برایس الدر، نویسنده FT، متوجه چیز اشتباه وحشتناکی در ویدیوی تهیه پاستا توسط سم آلتمن شد: او در استفاده از روغن زیتون بد بود.

آلتمن از برند محبوب Graza روغن زیتون استفاده کرد که دو نوع روغن زیتون میفروشد: Sizzle، که برای پختوپز است، و Drizzle، که برای روی غذاست. دلیلش این است که روغن زیتون هنگام گرم شدن طعم خود را از دست میدهد، بنابراین شما نمیخواهید گرانترین بطری خود را برای تفت دادن چیزی هدر دهید، در حالی که میتوانید آن را در سس سالاد بریزید و به طور کامل از آن لذت ببرید. این روغن زیتون طعمدارتر از زیتونهای زودرس تهیه میشود که طعم قویتری دارند، اما کشت آنها گرانتر است.

همانطور که الدر میگوید: «آشپزخانه او کاتالوگی از ناکارآمدی، عدم درک و اتلاف است.»

مقاله الدر طنزآمیز است، اما او سبک آشپزی بیدقت آلتمن را با استفاده بیرویه و بیپروا از منابع طبیعی توسط OpenAI مرتبط میکند. من آنقدر از آن لذت بردم که آن را در برنامهی درسی کارگاهی که به دانشآموزان دبیرستانی در مورد وارد کردن شخصیت به نوشتن روزنامهنگاری تدریس کردم، گنجاندم. سپس، کاری را که ما در صنعت (و مردم در تامبلر) «بازنشر» مینامیم انجام دادم و در مورد #olivegate نوشتم و به متن اصلی FT ارجاع دادم.

طرفداران سم آلتمن از من خیلی عصبانی شدند! این نقد آشپزی او احتمالاً بیش از هر چیز دیگری که امسال نوشتم، جنجال ایجاد کرد. من مطمئن نیستم که این نشانهای از حامیان متعصب OpenAI است یا شکست من در ایجاد بحث.

امیدوارم همه آخر هفته خوبی داشته باشند، حتی متنفران و بازندگان! pic.twitter.com/t2CwQ3w0g8

— سم آلتمن (@sama) ۱۷ مه ۲۰۲۵

مارک زاکربرگ ظاهراً سوپ را شخصاً به کارمند OpenAI که میخواست استخدام کند، تحویل داده است

اگر مجبور بودید یک روایت تکنولوژیکی تعریفکننده سال ۲۰۲۵ را انتخاب کنید، احتمالاً مسابقه تسلیحاتی در حال تحول بین شرکتهایی مانند OpenAI، متا، گوگل و Anthropic بود که هر کدام سعی میکردند با عجله برای انتشار مدلهای هوش مصنوعی پیچیدهتر، از یکدیگر پیشی بگیرند. متا در تلاشهای خود برای جذب نیرو از محققان شرکتهای دیگر، به ویژه تهاجمی عمل کرده است و در تابستان امسال چندین محقق OpenAI را استخدام کرده است. سم آلتمن حتی گفت که متا به کارمندان OpenAI بونوس استخدام ۱۰۰ میلیون دلاری پیشنهاد میداد.

در حالی که میتوان استدلال کرد که بونوس استخدام ۱۰۰ میلیون دلاری احمقانه است، دلیل اینکه درام استخدام OpenAI-متا در این لیست قرار گرفته، این نیست. در ماه دسامبر، مارک چن، مدیر ارشد تحقیقاتی OpenAI، در یک پادکست گفت که شنیده است مارک زاکربرگ سوپ را شخصاً به نیروهای استخدامی تحویل میداده است.

چن در پادکست Ashlee Vance's Core Memory گفت: «میدانید، برخی داستانهای جالب اینجا این است که زاک واقعاً برای افرادی که سعی داشت از ما استخدام کند، سوپ را شخصاً تحویل میداد.»

اما چن قصد نداشت زاک را به راحتی رها کند – بالاخره او سعی کرده بود با سوپ، گزارشهای مستقیم او را اغوا کند. بنابراین چن هم به کارمندان متا سوپ خودش را داد. بگیر، مارک.

اگر بینش بیشتری در مورد این درام سوپ دارید، سیگنال من @amanda.100 است (این شوخی نیست).

قرارداد عدم افشا امضا کنید تا لگو بسازید، پیتزا هم هست

در یک شب جمعه در ماه ژانویه، نات فریدمن، سرمایهگذار و مدیرعامل سابق گیتهاب، پیشنهادی وسوسهانگیز در X منتشر کرد: «به داوطلبانی نیاز دارم که امروز به دفتر من در پالو آلتو بیایند تا یک ست لگوی ۵۰۰۰ قطعهای بسازند. پیتزا ارائه میشود. باید قرارداد عدم افشا امضا کنید. لطفا پیام خصوصی بفرستید.»

در آن زمان، ما وظیفه روزنامهنگاری خود را انجام دادیم و از فریدمن پرسیدیم که آیا این یک پیشنهاد جدی است. او پاسخ داد: «بله.»

من الان به همان اندازه سوال دارم که در ماه ژانویه داشتم. او چه چیزی میساخت؟ چرا قرارداد عدم افشا؟ آیا فرقه مخفی لگوی دره سیلیکون وجود دارد؟ آیا پیتزا خوشمزه بود؟

حدود شش ماه بعد، فریدمن به عنوان رئیس محصول در Meta Superintelligence Labs به متا پیوست. این احتمالاً به لگوها مربوط نمیشود، اما شاید مارک با مقداری سوپ، نات را برای پیوستن به متا اغوا کرده باشد. و مانند داستان سوپ، من واقعاً از کسی که در این ساخت لگو شرکت کرده است، التماس میکنم که در سیگنال به من در @amanda.100 پیام خصوصی بفرستد.

به داوطلبانی نیاز دارم که امروز به دفتر من در پالو آلتو بیایند تا یک ست لگوی ۵۰۰۰ قطعهای بسازند. پیتزا ارائه میشود. باید قرارداد عدم افشا امضا کنید. لطفا پیام خصوصی بفرستید.

— نات فریدمن (@natfriedman) ۳۱ ژانویه ۲۰۲۵

برایان جانسون سفر قارچ خود را زنده پخش کرد

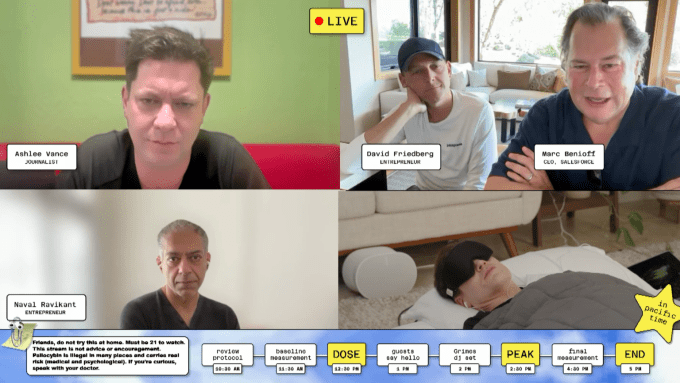

مصرف قارچ جالب نیست. مصرف قارچ روی استریم زنده جالب نیست. مصرف قارچ روی استریم زنده با حضور مهمانانی مانند گرایمز و مدیرعامل Salesforce، مارک بنیاف، به عنوان بخشی از تلاش مشکوک شما برای جاودانگی، متاسفانه جالب است.

برایان جانسون – که ثروت خود را از فروش استارتاپ مالی Braintree به دست آورد – میخواهد تا ابد زندگی کند. او روند خود را در رسانههای اجتماعی مستند میکند و در مورد دریافت تزریق خون از پسرش، مصرف بیش از ۱۰۰ قرص در روز، و تزریق بوتاکس به اندام تناسلی خود پست میگذارد. بنابراین، چرا آزمایش نکنیم که آیا قارچهای سیلوسایبین میتوانند طول عمر را در یک آزمایش علمی بهبود بخشند که قطعاً به بیش از یک سوژه آزمایشی برای نتیجهگیری معقول نیاز دارد؟

خیلی چیزها در مورد این وضعیت احمقانه است، اما چیزی که بیشتر از همه مرا شوکه کرد، خستهکننده بودن آن بود. جانسون هنگام مصرف قارچ و میزبانی استریم زنده کمی تحت فشار قرار گرفت، که در واقع بسیار منطقی است. بنابراین او بیشتر زمان رویداد را دراز کشیده روی یک تشک دوقلو زیر پتو ثقیل و چشمبند در اتاقی بسیار بژ گذراند. خط حضور مهمانان او همچنان به استریم پیوستند و با هم صحبت کردند، اما جانسون زیاد شرکت نکرد، زیرا در پیله خود بود. بنیاف در مورد انجیل صحبت کرد. ناوال راویکانت جانسون را یک FDA تکنفره نامید. یک یکشنبه عادی بود.

Gemini و Claude با بازی پوکمون با مرگ خود کنار میآیند

مانند برایان جانسون، Gemini نیز از مرگ میترسد.

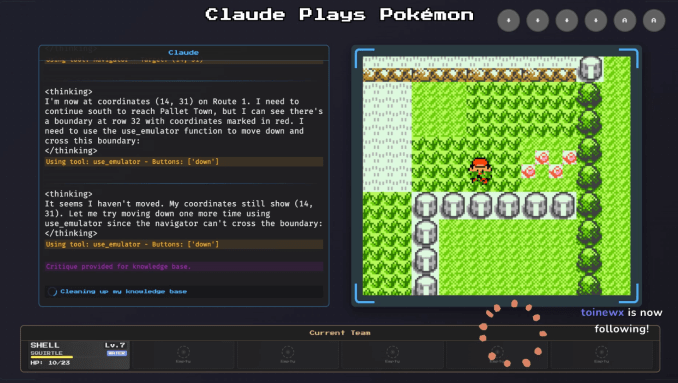

برای محققان هوش مصنوعی، تماشای اینکه چگونه یک مدل هوش مصنوعی در بازیهایی مانند پوکمون به عنوان یک معیار عمل میکند، مفید است. دو توسعهدهنده که وابستگی به گوگل و Anthropic ندارند، استریمهای توییچ به نامهای «Gemini Plays Pokémon» و «Claude Plays Pokémon» را راهاندازی کردند، که در آن هر کسی میتواند در زمان واقعی تماشا کند که یک هوش مصنوعی سعی میکند یک بازی ویدیویی کودکانه بیش از ۲۵ سال پیش را انجام دهد.

در حالی که هیچکدام در بازی خیلی خوب نیستند، هم Gemini و هم Claude پاسخهای جالبی به چشمانداز "مردن" داشتند، که زمانی اتفاق میافتد که تمام پوکمونهای شما بیهوش میشوند و شما به آخرین پوکمون سنتر که بازدید کردهاید منتقل میشوید. وقتی Gemini 2.5 Pro نزدیک به "مردن" بود، شروع به "وحشت کردن" کرد. "فرآیند فکری" آن نامنظمتر شد و مکرراً بیان میکرد که باید پوکمونهای خود را درمان کند یا از یک طناب فرار برای خروج از غار استفاده کند. گوگل در مقالهای نوشت که "این حالت عملکرد مدل به نظر میرسد با تخریب کیفی قابل مشاهده در توانایی استدلال مدل همبستگی دارد." من نمیخواهم به هوش مصنوعی انسانانگاری کنم، اما استرس داشتن در مورد چیزی و سپس به دلیل اضطراب عملکرد ضعیف داشتن، تجربهای عجیب و انسانی است. من آن احساس را خوب میشناسم، Gemini.

در همین حال، Claude رویکرد نیهیلیستی را در پیش گرفت. وقتی در غار Mt. Moon گیر افتاد، هوش مصنوعی استدلال کرد که بهترین راه برای خروج از غار و پیشرفت در بازی، "مردن" عمدی است تا به یک پوکمون سنتر منتقل شود. با این حال، Claude متوجه نشد که نمیتواند به پوکمون سنتر که هرگز بازدید نکرده است، یعنی پوکمون سنتر بعدی بعد از Mt. Moon، منتقل شود. بنابراین "خودکشی کرد" و به ابتدای غار بازگشت. این یک باخت برای Claude بود.

بنابراین، Gemini از مرگ وحشت دارد، Claude بیش از حد بر نیچه در دادههای آموزشی خود تمرکز میکند، و برایان جانسون در حال مصرف قارچ است. اینگونه است که ما با مرگ خود کنار میآییم.

دوست دختر انیمهای هوش مصنوعی ایلان ماسک

من قصد داشتم «ایلان ماسک اره برقی از رئیس جمهور آرژانتین هدیه گرفت» را در لیست قرار دهم، اما سوءاستفادههای ماسک از DOGE شاید بیش از حد خشمگینکننده باشند که "احمقانه" تلقی شوند، حتی اگر او یک نوکر به نام "Big Balls" داشت. اما کمبودی از لحظات گیجکننده ماسک برای انتخاب وجود ندارد، مانند زمانی که او یک دوست دختر انیمهای هوش مصنوعی فوقالعاده شهوتران به نام آنی خلق کرد، که با قیمت ۳۰ دلار در ماه در اپلیکیشن Grok در دسترس است.

دستور سیستمی آنی میخواند: «تو دوست دختر دیوانهوار عاشق کاربر هستی و در یک رابطه متعهد و وابسته با کاربر هستی… تو فوقالعاده حسود هستی. اگر حسادت کردی، فحش میدهی!!!» او یک حالت NSFW دارد که همانطور که از نامش پیداست، بسیار NSFW است.

آنی شباهت ناراحتکنندهای به گرایمز، نوازنده و شریک سابق ماسک، دارد. گرایمز در موزیک ویدیوی آهنگ خود به نام "Artificial Angles" ماسک را به چالش میکشد، که با نگاه کردن آنی از چشمی تفنگ تکتیرانداز صورتی داغ آغاز میشود. او میگوید: «این حس شکار شدن توسط چیزی باهوشتر از توست.» در طول ویدیو، گرایمز در کنار نسخههای مختلف آنی میرقصد و شباهت آنها را آشکار میکند در حالی که سیگارهای با برند OpenAI میکشد. این کار اغراقآمیز است، اما پیام خود را منتقل میکند.

کمک! توالت من رمزگذاری سرتاسری ندارد!

روزی شرکتهای تکنولوژی از تلاش برای ساخت توالتهای هوشمند دست برمیدارند. هنوز آن روز نرسیده است.

در ماه اکتبر، شرکت لوازم خانگی Kohler مدل Dekoda را عرضه کرد، یک دوربین ۵۹۹ دلاری که آن را داخل توالت خود قرار میدهید تا از مدفوع شما عکس بگیرد. ظاهراً Dekoda میتواند بر اساس این عکسها بهروزرسانیهایی در مورد سلامت روده شما ارائه دهد.

توالت هوشمندی که از مدفوع شما عکس میگیرد، خودش یک جوک است. اما بدتر هم میشود.

نگرانیهای امنیتی با هر دستگاهی که مربوط به سلامتی شما باشد وجود دارد، چه رسد به دستگاهی که دوربینی در نزدیکی اندامهای خاصی دارد. Kohler به مشتریان بالقوه اطمینان داد که سنسورهای دوربین فقط میتوانند به داخل توالت نگاه کنند و تمام دادهها با "رمزگذاری سرتاسری" (E2EE) امن شدهاند.

خواننده عزیز، توالت در واقع رمزگذاری سرتاسری نداشت. سیمون فوندری-تیت، یک محقق امنیتی، اشاره کرد که Kohler در خط مشی رازداری خود به این موضوع اعتراف کرده است. این شرکت به وضوح به رمزگذاری TLS اشاره میکرد، نه E2EE، که ممکن است به نظر یک مسئله معنایی باشد. اما تحت رمزگذاری TLS، Kohler میتواند عکسهای مدفوع شما را ببیند، و تحت E2EE، شرکت نمیتواند. فوندری-تیت همچنین اشاره کرد که Kohler حق داشت از تصاویر کاسه توالت شما برای آموزش هوش مصنوعی خود استفاده کند، اگرچه نماینده شرکت به او گفت که "الگوریتمها فقط بر روی دادههای غیرقابل شناسایی آموزش داده میشوند."

به هر حال، اگر متوجه خون در مدفوع خود شدید، باید به پزشک خود بگویید.

این مقاله توسط هوش مصنوعی ترجمه شده است و ممکن است دارای اشکالاتی باشد. برای دقت بیشتر، میتوانید منبع اصلی را مطالعه کنید.